Los investigadores de NVIDIA están a la vanguardia en el campo de la IA generativa visual, desarrollando nuevas técnicas para crear e interpretar imágenes, videos y entornos 3D.

Más de 50 de estos proyectos se presentarán en la conferencia Computer Vision and Pattern Recognition (CVPR), que se llevará a cabo del 17 al 21 de junio en Seattle. Dos de los artículos —uno sobre la dinámica de entrenamiento de modelos de difusión y otro sobre mapas de alta definición para vehículos autónomos— son finalistas para los Premios al Mejor Artículo del CVPR.

NVIDIA también es el ganador de la pista de Conducción Autónoma a Escala del Desafío Autónomo del CVPR, un hito significativo que demuestra el uso de la IA generativa para modelos completos de autoconducción. La presentación ganadora, que superó a más de 450 entradas a nivel mundial, también recibió el Premio a la Innovación del CVPR.

La investigación de NVIDIA en el CVPR incluye un modelo de texto a imagen que puede personalizarse fácilmente para representar un objeto o personaje específico, un nuevo modelo para la estimación de poses de objetos, una técnica para editar campos de radiancia neural (NeRFs), y un modelo de lenguaje visual que puede entender memes. Además, otros artículos presentan innovaciones específicas para sectores como el automotriz, el de la salud y la robótica.

En conjunto, este trabajo introduce poderosos modelos de IA que podrían permitir a los creadores materializar sus visiones artísticas más rápidamente, acelerar el entrenamiento de robots autónomos para la manufactura y apoyar a los profesionales de la salud en el procesamiento de informes radiológicos.

“La inteligencia artificial, y en particular la IA generativa, representa un avance tecnológico fundamental,” dijo Jan Kautz, vicepresidente de investigación de aprendizaje y percepción en NVIDIA. “En el CVPR, NVIDIA Research está compartiendo cómo estamos empujando los límites de lo que es posible, desde potentes modelos de generación de imágenes que podrían potenciar a creadores profesionales hasta software de conducción autónoma que podría habilitar la próxima generación de coches autónomos.”

En el CVPR, NVIDIA también anunció NVIDIA Omniverse Cloud Sensor RTX, un conjunto de microservicios que permiten simulación de sensores físicamente precisos para acelerar el desarrollo de máquinas totalmente autónomas de todo tipo.

Forget Fine-Tuning: JeDi simplifica la generación de imágenes personalizadas

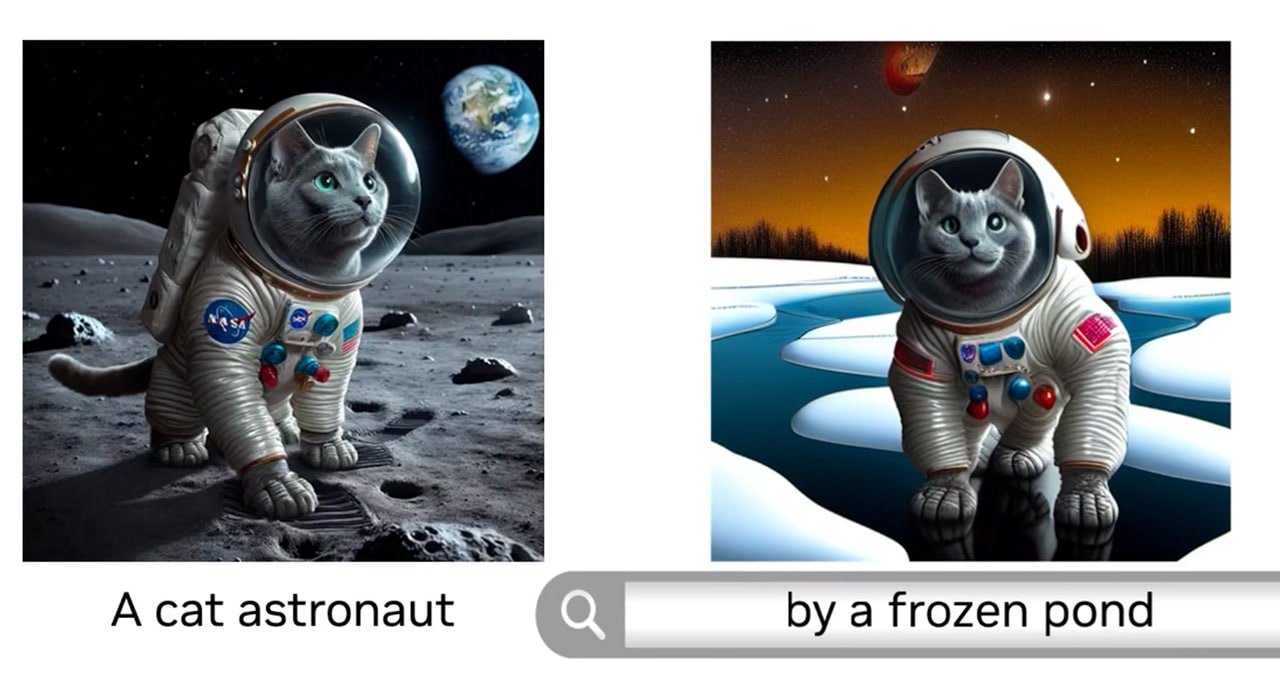

Los creadores que utilizan modelos de difusión, el método más popular para generar imágenes basadas en indicaciones textuales, a menudo tienen en mente un personaje u objeto específico —pueden, por ejemplo, estar desarrollando una historia animada en torno a un ratón o ideando una campaña publicitaria para un juguete específico.

Investigaciones anteriores han permitido a estos creadores personalizar la salida de los modelos de difusión para centrarse en un sujeto específico mediante la afinación —donde un usuario entrena el modelo en un conjunto de datos personalizado— pero el proceso puede ser largo y poco accesible para usuarios generales.

JeDi, un artículo de investigadores de la Universidad Johns Hopkins, el Instituto Tecnológico de Toyota en Chicago y NVIDIA, propone una nueva técnica que permite a los usuarios personalizar fácilmente la salida de un modelo de difusión en un par de segundos usando imágenes de referencia. El equipo descubrió que el modelo logra una calidad de vanguardia, superando significativamente a los métodos existentes basados en afinación y sin afinación.

JeDi también puede combinarse con la generación aumentada por recuperación (RAG) para generar visuales específicos a una base de datos, como el catálogo de productos de una marca.

New foundation model perfecciona la pose

Los investigadores de NVIDIA en CVPR también están presentando FoundationPose, un modelo de base para la estimación y el seguimiento de poses de objetos que puede aplicarse instantáneamente a nuevos objetos durante la inferencia, sin necesidad de afinación.

El modelo, que estableció un nuevo récord en un popular benchmark para la estimación de poses de objetos, usa un pequeño conjunto de imágenes de referencia o una representación 3D de un objeto para comprender su forma. Luego puede identificar y rastrear cómo se mueve y rota ese objeto en 3D a lo largo de un video, incluso en condiciones de poca luz o en escenas complejas con obstrucción visual.

FoundationPose podría usarse en aplicaciones industriales para ayudar a robots autónomos a identificar y rastrear los objetos con los que interactúan. También podría usarse en aplicaciones de realidad aumentada donde un modelo de IA se usa para superponer visuales en una escena en vivo.

NeRFDeformer transforma escenas 3D con una sola instantánea

Un NeRF es un modelo de IA que puede renderizar una escena 3D basándose en una serie de imágenes 2D tomadas desde diferentes posiciones en el entorno. En campos como la robótica, los NeRFs pueden usarse para generar renders 3D inmersivos de escenas del mundo real complejas, como una habitación desordenada o un sitio de construcción. Sin embargo, para hacer cualquier cambio, los desarrolladores tendrían que definir manualmente cómo se ha transformado la escena o rehacer el NeRF por completo.

Investigadores de la Universidad de Illinois Urbana-Champaign y NVIDIA han simplificado el proceso con NeRFDeformer. El método, presentado en el CVPR, puede transformar exitosamente un NeRF existente utilizando una sola imagen RGB-D, que es una combinación de una foto normal y un mapa de profundidad que captura la distancia de cada objeto en una escena desde la cámara.

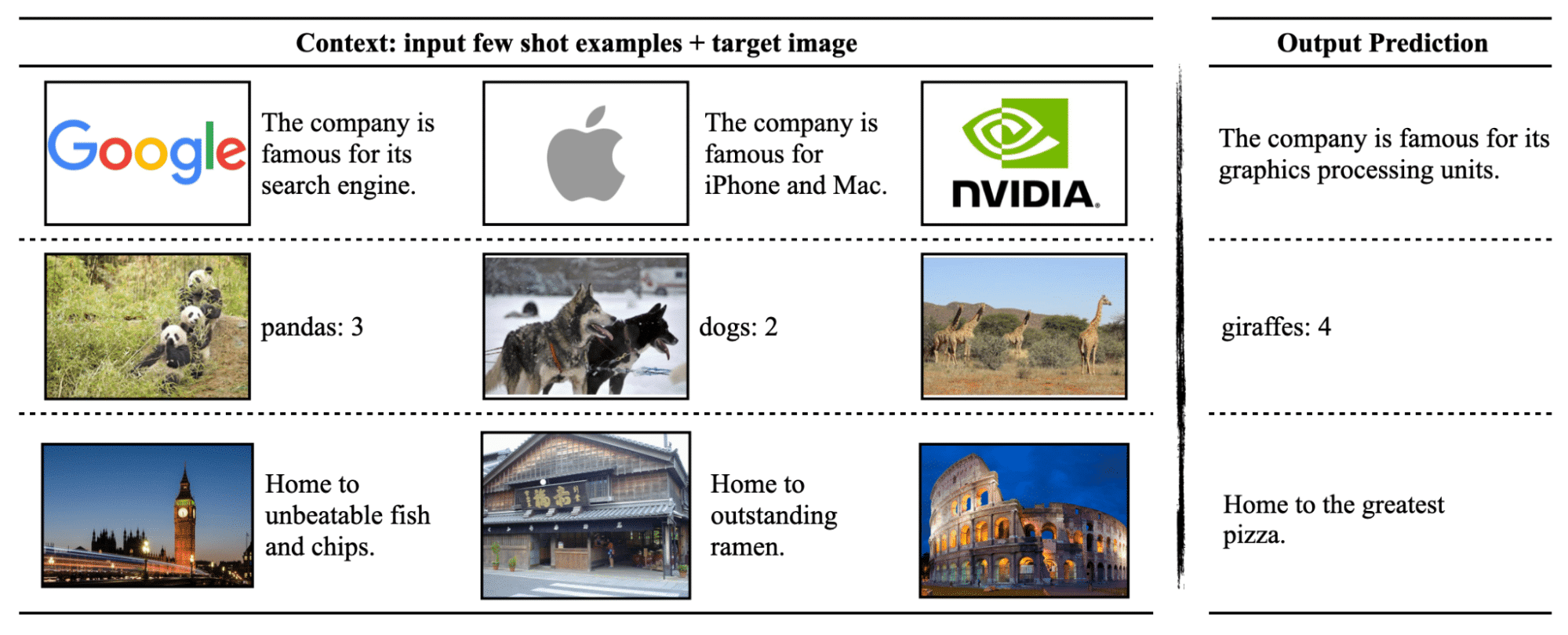

VILA visual language model comprende las imágenes

Una colaboración de investigación en CVPR entre NVIDIA y el Instituto Tecnológico de Massachusetts está avanzando el estado del arte para los modelos de lenguaje visual, que son modelos de IA generativa capaces de procesar videos, imágenes y texto.

El grupo desarrolló VILA, una familia de modelos de lenguaje visual de código abierto que superan a redes neuronales anteriores en benchmarks clave que prueban cómo los modelos de IA responden preguntas sobre imágenes. El proceso de preentrenamiento único de VILA desbloqueó nuevas capacidades del modelo, incluyendo un conocimiento mundial mejorado, mejor aprendizaje en contexto y la capacidad de razonar a través de múltiples imágenes.

Generative AI impulsa la conducción autónoma y la investigación en ciudades inteligentes

Una docena de los artículos de NVIDIA en el CVPR se centran en la investigación de vehículos autónomos. Otros aspectos destacados relacionados con AV incluyen:

También en el CVPR, NVIDIA contribuyó con el mayor conjunto de datos sintéticos de interiores jamás creado al AI City Challenge, ayudando a investigadores y desarrolladores a avanzar en el desarrollo de soluciones para ciudades inteligentes y automatización industrial. Los conjuntos de datos del desafío fueron generados utilizando NVIDIA Omniverse, una plataforma de API, SDK y servicios que permiten a los desarrolladores construir aplicaciones y flujos de trabajo basados en Universal Scene Description (OpenUSD).

NVIDIA Research cuenta con cientos de científicos e ingenieros en todo el mundo, con equipos enfocados en temas como IA, gráficos por computadora, visión por computadora, coches autónomos y robótica.