Large language models y las aplicaciones que impulsan ofrecen oportunidades sin precedentes para que las organizaciones obtengan insights más profundos de sus reservas de datos y construyan clases de aplicaciones completamente nuevas. Sin embargo, con las oportunidades frecuentemente surgen desafíos. Tanto en las instalaciones como en la nube, las aplicaciones que se espera que funcionen en tiempo real imponen demandas significativas sobre la infraestructura del centro de datos para proporcionar alto rendimiento y baja latencia con una sola inversión en la plataforma.

Mejoras constantes

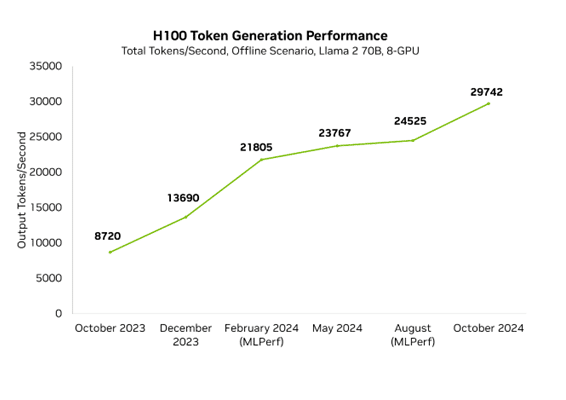

Las mejoras en el rendimiento permiten a nuestros clientes y socios atender modelos más complejos y reducir la infraestructura necesaria para albergarlos. NVIDIA optimiza el rendimiento en cada capa de la pila tecnológica, incluyendo TensorRT-LLM, una biblioteca diseñada para ofrecer rendimiento de vanguardia en los modelos de lenguaje más recientes. Con las mejoras en el modelo Llama 70B, que ofrece una muy alta precisión, ya habíamos aumentado el rendimiento mínimo de latencia en un 3,5x en menos de un año.

Constantemente mejoramos el rendimiento de nuestra plataforma y publicamos regularmente actualizaciones de rendimiento. Cada semana, se publican mejoras en las bibliotecas de software de NVIDIA, permitiendo a los clientes obtener más de las mismas GPU. Por ejemplo, en solo unos meses, mejoramos nuestro rendimiento de Llama 70B en baja latencia en un 3,5x.

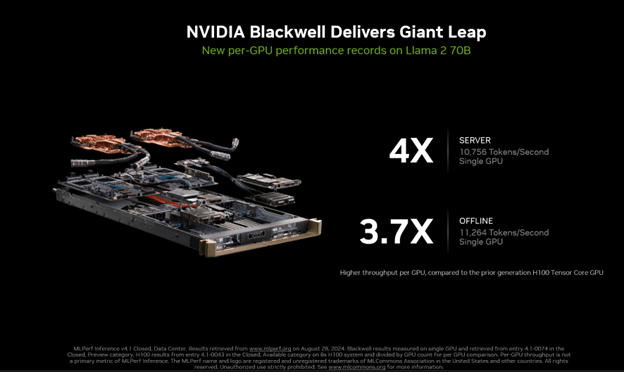

En la más reciente ronda de MLPerf Inference, realizamos nuestra primera presentación con la plataforma Blackwell, que mostró un rendimiento 4 veces superior a la generación anterior. Esta presentación fue también la primera en MLPerf en utilizar precisión FP4. Los formatos de precisión más reducidos, como FP4, disminuyen el consumo de memoria y el tráfico de memoria, además de aumentar el rendimiento computacional. El proceso aprovecha el segundo motor de Transformer de Blackwell y, con técnicas avanzadas de cuantización que forman parte de TensorRT Model Optimizer, la presentación de Blackwell cumplió con los estrictos objetivos de precisión del benchmark de MLPerf.

Las mejoras en Blackwell no han detenido la continua aceleración de Hopper. En el último año, el rendimiento de Hopper se incrementó en un 3.4x en MLPerf en H100 gracias a los avances regulares en el software. Esto significa que el rendimiento máximo de NVIDIA en ese momento, en Blackwell, era 10 veces más rápido que hace solo un año en Hopper.

Nuestro continuo trabajo se incorpora en TensorRT-LLM, una biblioteca diseñada para acelerar modelos de lenguaje que contiene optimizaciones de vanguardia para realizar inferencia de manera eficiente en las GPU de NVIDIA. TensorRT-LLM se construye sobre la biblioteca TensorRT Deep Learning Inference y aprovecha gran parte de las optimizaciones de TensorRT para el aprendizaje profundo con mejoras específicas para LLM.

Optimización de Llama de manera significativa

Recientemente, continuamos optimizando variantes de los modelos Llama de Meta, incluyendo las versiones 3.1 y 3.2 así como los tamaños de modelo 70B y el más grande, 405B. Estas optimizaciones incluyen recetas de cuantización personalizadas, así como un uso eficiente de técnicas de paralelización para dividir el modelo de manera eficiente entre múltiples GPU, aprovechando las tecnologías de interconexión NVIDIA NVLink y NVSwitch. Los modelos de vanguardia como Llama 3.1 405B son muy exigentes y requieren el rendimiento combinado de varias GPU de última generación para obtener respuestas rápidas.

Las técnicas de paralelismo requieren una plataforma de hardware con un robusto tejido de interconexión GPU a GPU para maximizar el rendimiento y evitar cuellos de botella en la comunicación. Cada GPU H200 Tensor Core de NVIDIA cuenta con NVLink de cuarta generación, que proporciona un asombroso ancho de banda de 900GB/s de GPU a GPU. Cada plataforma HGX H200 de ocho GPU también incluye cuatro NVLink Switches, lo que permite que cada GPU H200 se comunique con cualquier otra GPU H200 a 900GB/s, simultáneamente.

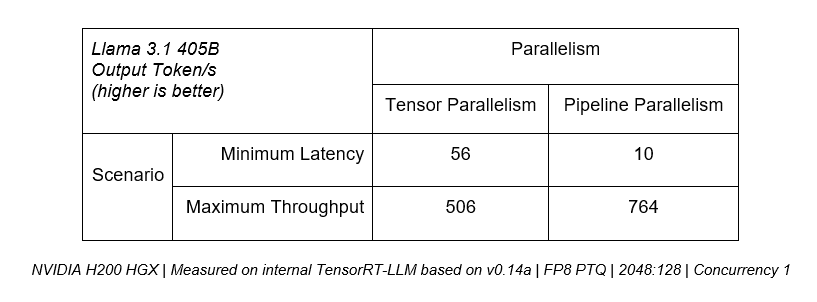

Muchas implementaciones de LLM utilizan paralelismo en lugar de optar por mantener la carga de trabajo en una sola GPU, que puede presentar cuellos de botella de cómputo. Los modelos de lenguaje buscan equilibrar baja latencia y alto rendimiento, con la técnica óptima de paralelización dependiendo de los requisitos de la aplicación.

Por ejemplo, si la latencia más baja es la prioridad, el paralelismo tensorial es crítico, ya que el rendimiento combinado de múltiples GPU se puede utilizar para servir tokens a los usuarios más rápido. Sin embargo, para casos de uso donde se prioriza el rendimiento máximo entre todos los usuarios, el paralelismo por pipeline puede aumentar eficientemente el rendimiento general del servidor.

La tabla a continuación muestra que el paralelismo tensorial puede ofrecer más de 5x el rendimiento en escenarios de latencia mínima, mientras que el paralelismo por pipeline proporciona un 50% más de rendimiento para casos de uso de rendimiento máximo. Para las implementaciones de producción que buscan maximizar el rendimiento dentro de un presupuesto de latencia dado, una plataforma necesita ofrecer la capacidad de combinar eficazmente ambas técnicas como en TensorRT-LLM.

Un ciclo virtuoso

A lo largo del ciclo de vida de nuestras arquitecturas, logramos ganancias significativas en rendimiento gracias al ajuste y optimización de software continuos. Estas mejoras se traducen en un mayor valor para los clientes que entrenan e implementan en nuestras plataformas. Pueden crear modelos y aplicaciones más capaces y desplegar sus modelos existentes utilizando menos infraestructura, mejorando así su ROI.

A medida que nuevos LLM y otros modelos de inteligencia artificial generativa continúan llegando al mercado, NVIDIA seguirá optimizándolos en sus plataformas y facilitando su implementación con tecnologías como NIM microservices y NIM Agent Blueprints.