Desde su introducción, la NVIDIA Hopper architecture ha transformado el panorama de la inteligencia artificial y la computación de alto rendimiento (HPC), ayudando a empresas, investigadores y desarrolladores a enfrentar los desafíos más complejos del mundo con mayor rendimiento y eficiencia energética.

Anuncio de H200 NVL en Supercomputing 2024

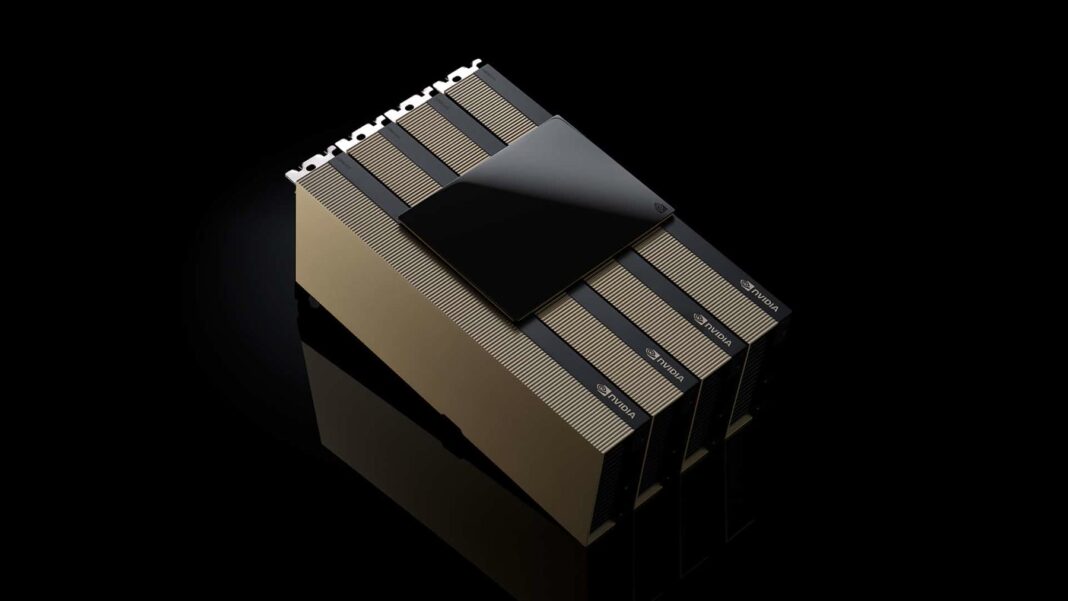

Durante la conferencia de Supercomputing 2024, NVIDIA anunció la disponibilidad de la NVIDIA H200 NVL PCIe GPU, la última incorporación a la familia Hopper. H200 NVL es ideal para organizaciones con centros de datos que buscan diseños de rack empresariales con menor consumo de energía y refrigeración por aire, brindando configuraciones flexibles para acelerar cada carga de trabajo de IA y HPC, independientemente de su tamaño.

Demandas de GPU PCIe

De acuerdo a una encuesta reciente, aproximadamente el 70% de los racks empresariales son de 20kW o menos y utilizan refrigeración por aire. Esto hace que los GPUs PCIe sean fundamentales, ya que proporcionan granularidad en el despliegue de nodos, ya sea utilizando uno, dos, cuatro u ocho GPUs, lo que permite a los centros de datos acomodar más potencia de computación en espacios más pequeños. Así, las empresas pueden usar sus racks existentes y seleccionar el número de GPUs que mejor se adapte a sus necesidades.

Las empresas pueden utilizar H200 NVL para acelerar aplicaciones de IA y HPC, mejorando también la eficiencia energética a través de una reducción en el consumo eléctrico. Con un aumento en la memoria de 1.5x y un incremento en el ancho de banda de 1.2x en comparación con la NVIDIA H100 NVL, las empresas podían ajustar LLMs en unas pocas horas y ofrecer un rendimiento de inferencia hasta 1.7x más rápido. Para las cargas de trabajo HPC, el rendimiento se potenciaba hasta 1.3x en comparación con H100 NVL y 2.5x en comparación con la generación de arquitectura NVIDIA Ampere.

Potencia del H200 NVL

Complementando la potencia bruta del H200 NVL está la tecnología NVIDIA NVLink. La última generación de NVLink proporciona comunicación GPU a GPU 7 veces más rápida que la PCIe de quinta generación, ofreciendo un mayor rendimiento para satisfacer las necesidades de HPC, inferencia de grandes modelos de lenguaje y ajuste fino.

La NVIDIA H200 NVL se acompaña de poderosas herramientas de software que permiten a las empresas acelerar aplicaciones de IA a HPC. Viene con una suscripción de cinco años para NVIDIA AI Enterprise, una plataforma de software nativa en la nube para el desarrollo y despliegue de IA en producción. NVIDIA AI Enterprise incluye NVIDIA NIM microservicios para el despliegue seguro y confiable de inferencia de modelos de IA de alto rendimiento.

Empresas que Aprovechan el Poder de H200 NVL

Con H200 NVL, NVIDIA proporciona a las empresas una plataforma completa para desarrollar y desplegar sus cargas de trabajo de IA y HPC. Los clientes estaban experimentando un impacto significativo en múltiples casos de uso de IA y HPC en diversas industrias, como agentes de IA visual y chatbots para atención al cliente, algoritmos de trading para finanzas, imágenes médicas para una mejor detección de anomalías en salud, reconocimiento de patrones para manufactura y formación sísmica para organizaciones científicas federales.

Dropbox está aprovechando la computación acelerada por NVIDIA para sus servicios e infraestructuras. “Dropbox maneja grandes cantidades de contenido, lo que requiere capacidades avanzadas de IA y aprendizaje automático,” dijo Ali Zafar, VP de Infraestructura en Dropbox. “Estamos explorando H200 NVL para seguir mejorando nuestros servicios y brindar más valor a nuestros clientes.”

La Universidad de Nuevo México había estado utilizando la computación acelerada por NVIDIA en diversas aplicaciones de investigación y académicas. “Como universidad pública de investigación, nuestro compromiso con la IA permite a la universidad estar a la vanguardia de los avances científicos y tecnológicos,” expresó el Prof. Patrick Bridges, director del Centro de Investigación Avanzada en Computación de la UNM. “Al cambiar a H200 NVL, podremos acelerar una variedad de aplicaciones, incluyendo iniciativas de ciencia de datos, bioinformática e investigación genómica, simulaciones en física y astronomía, modelado climático y más.”

H200 NVL Disponible en Todo el Ecosistema

Dell Technologies, Hewlett Packard Enterprise, Lenovo y Supermicro estaban programados para ofrecer una amplia gama de configuraciones que soportaran H200 NVL. Además, H200 NVL estaría disponible en plataformas de Aivres, ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, MSI, Pegatron, QCT, Wistron y Wiwynn.

Algunos sistemas estaban basados en la arquitectura modular NVIDIA MGX, que permitía a los fabricantes de computadoras construir rápida y económicamente una vasta gama de diseños de infraestructura de centros de datos.

Las plataformas con H200 NVL estarían disponibles a partir de diciembre a través de los socios globales de sistemas de NVIDIA. Para complementar la disponibilidad de los principales socios globales, NVIDIA también estaba desarrollando una Arquitectura de Referencia Empresarial para sistemas H200 NVL. Esta arquitectura de referencia incorporaría la experiencia y principios de diseño de NVIDIA, permitiendo a socios y clientes diseñar y desplegar infraestructuras de IA de alto rendimiento basadas en H200 NVL a gran escala. Esto incluye recomendaciones de hardware y software de pila completa, con orientación detallada sobre las configuraciones óptimas de servidores, clústeres y redes. La red estaba optimizada para el más alto rendimiento con la plataforma de Ethernet NVIDIA Spectrum-X.

Las tecnologías de NVIDIA se exhibirían en el piso de exhibición en SC24, que se realizaría en el Centro de Convenciones Mundial de Georgia.