Generative AI y los modelos fundamentales permiten que las máquinas autónomas generalicen más allá de los dominios de diseño operativo en los que han sido entrenadas. Utilizando nuevas técnicas de inteligencia artificial, como la tokenización y los modelos de lenguaje y difusión, desarrolladores e investigadores pueden abordar obstáculos duraderos para la autonomía.

Desafíos en la recolección de datos

Estos modelos más grandes requieren enormes cantidades de datos diversos para el entrenamiento, ajuste fino y validación. Sin embargo, recolectar tales datos, incluidos casos raros y escenarios potencialmente peligrosos, como un peatón cruzando frente a un vehículo autónomo por la noche o un humano ingresando a una celda de trabajo de un robot de soldadura, puede ser increíblemente complicado y consumir muchos recursos.

Facilitando el desarrollo de datos con NVIDIA

Para ayudar a los desarrolladores a llenar este vacío, las APIs de sensores RTX de NVIDIA Omniverse Cloud permiten simulaciones de sensores físicamente precisas para generar conjuntos de datos a gran escala. Estas interfaces de programación de aplicaciones (APIs) están diseñadas para soportar sensores comúnmente utilizados en autonomía, incluyendo cámaras, radar y lidar, y pueden integrarse sin problemas en flujos de trabajo existentes para acelerar el desarrollo de vehículos y robots autónomos de todo tipo.

Las APIs de Sensor RTX de Omniverse están ahora disponibles para desarrolladores selectos en acceso anticipado. Organizaciones como Accenture, Foretellix, MITRE y Mcity están integrando estas APIs a través de planos específicos del dominio para proporcionar a los clientes finales las herramientas necesarias para desplegar la próxima generación de robots industriales y vehículos autónomos.

Impulse industrial con los planos de Omniverse

En entornos complejos como fábricas y almacenes, los robots deben ser coordinados para trabajar de manera segura y eficiente junto a la maquinaria y los trabajadores humanos. Todos esos componentes en movimiento presentan un gran desafío al diseñar, probar o validar operaciones sin causar interrupciones.

Mega es un plano de Omniverse que ofrece a las empresas una arquitectura de referencia de computación acelerada por NVIDIA, inteligencia artificial, NVIDIA Isaac y NVIDIA Omniverse. Las empresas pueden usarlo para desarrollar gemelos digitales y probar cerebros robóticos impulsados por inteligencia artificial que controlan robots, cámaras, equipos y más para manejar una enorme complejidad y escala.

Integrando Sensor RTX de Omniverse, el plano permite a los desarrolladores de robótica renderizar simultáneamente los datos de sensores de cualquier tipo de máquina inteligente en una fábrica para simulaciones de sensores de alta fidelidad y gran escala.

Con la capacidad de probar operaciones y flujos de trabajo en simulación, los fabricantes pueden ahorrar tiempo e inversión considerable, y mejorar la eficiencia de maneras completamente nuevas.

La empresa internacional de soluciones de cadena de suministro KION Group y Accenture están utilizando el plano Mega para construir gemelos digitales en Omniverse que sirvan como entornos virtuales de entrenamiento y prueba para los cerebros robóticos de la inteligencia industrial, aprovechando datos de cámaras inteligentes, carretillas elevadoras, equipos robóticos y humanos digitales.

Los cerebros robóticos perciben el entorno simulado con datos de sensores físicamente precisos generados por las APIs de Sensor RTX de Omniverse. Utilizan estos datos para planificar y actuar, con cada acción registrada de manera precisa junto con el estado y la posición de todos los activos en el gemelo digital. Con estas capacidades, los desarrolladores pueden construir y probar continuamente nuevos diseños antes de que se implementen en el mundo físico.

Avanzando en el desarrollo y validación de vehículos autónomos

Los vehículos autónomos estuvieron en desarrollo durante más de una década, pero las barreras para adquirir los datos de entrenamiento y validación adecuados y los lentos ciclos de iteración obstaculizaron el despliegue a gran escala.

Para abordar esta necesidad de datos de sensores, las empresas están aprovechando el Plano de Omniverse para simulación de vehículos autónomos, un flujo de trabajo de referencia que permite simulaciones de sensores físicamente precisas. El flujo de trabajo utiliza las APIs de Sensor RTX de Omniverse para renderizar los datos de cámara, radar y lidar necesarios para el desarrollo y la validación de vehículos autónomos.

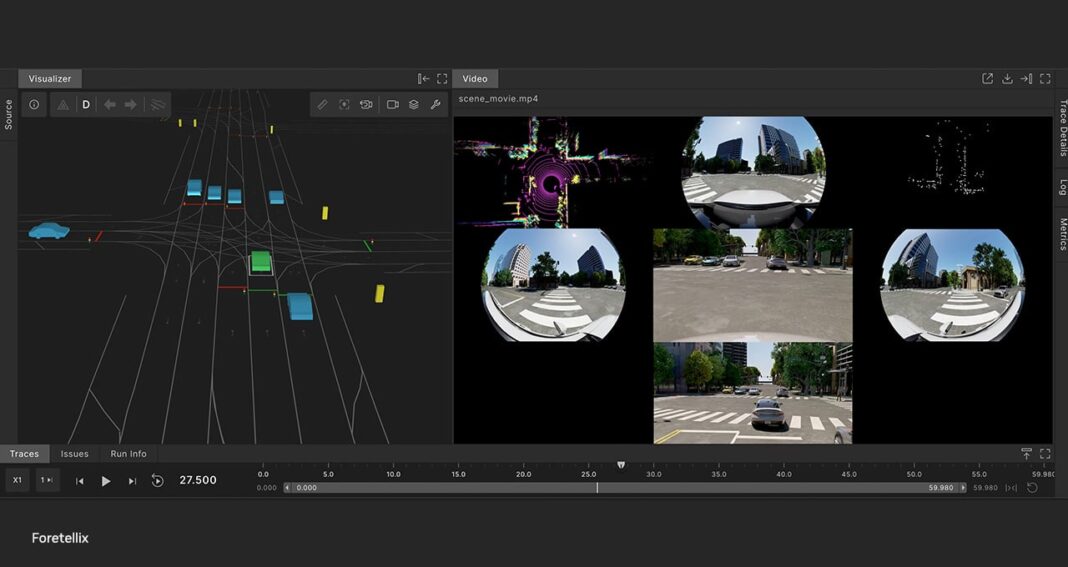

El proveedor de cadenas de herramientas AV, Foretellix, integró el plano en su cadena de herramientas de desarrollo Foretify AV para transformar la simulación a nivel de objeto en simulación de sensores físicamente precisa.

La cadena de herramientas Foretify puede generar cualquier número de escenarios de prueba simultáneamente. Al añadir capacidades de simulación de sensores a estos escenarios, Foretify ahora puede permitir a los desarrolladores evaluar la integridad de su desarrollo de vehículos autónomos, así como capacitar y probar en los niveles de fidelidad y escala necesarios para lograr un despliegue seguro y a gran escala. Además, Foretellix utilizará la recién anunciada plataforma NVIDIA Cosmos para generar una diversidad aún mayor de escenarios para la verificación y validación.

Nuro, un proveedor de tecnología de conducción autónoma con uno de los despliegues de nivel 4 más grandes en los Estados Unidos, está utilizando la cadena de herramientas Foretify para entrenar, probar y validar sus vehículos autónomos antes de su despliegue.

Además, la organización de investigación MITRE está colaborando con la instalación de pruebas Mcity de la Universidad de Michigan para construir un marco de validación digital para vehículos autónomos de uso regulatorio, que incluye un gemelo digital del terreno de pruebas de 32 acres de Mcity para vehículos autónomos. El proyecto utiliza el plano de simulación de vehículos autónomos para renderizar datos de sensores físicamente precisos a gran escala en el entorno virtual, aumentando la efectividad del entrenamiento.

El futuro de la robótica y la autonomía se acerca a un enfoque claro, gracias al poder de la simulación de sensores de alta fidelidad.