The recently released DeepSeek-R1 model family ha generado una nueva ola de entusiasmo en la comunidad de IA, permitiendo a entusiastas y desarrolladores ejecutar modelos de razonamiento de última generación con capacidades de resolución de problemas, matemáticas y código, todo desde la privacidad de sus PCs locales. Con hasta 3,352 billones de operaciones por segundo de potencia de IA, las GPUs de la serie NVIDIA GeForce RTX 50 pueden ejecutar la familia de modelos destilados DeepSeek más rápido que cualquier otro en el mercado de PC.

Una nueva clase de modelos que razonan

Los modelos de razonamiento son una nueva clase de modelos de lenguaje grande que pasan más tiempo “pensando” y “reflexionando” para enfrentar problemas complejos, mientras describen los pasos necesarios para resolver una tarea. El principio fundamental es que cualquier problema se puede resolver con un profundo pensamiento, razonamiento y tiempo, al igual que los humanos abordan sus problemáticas. Al dedicar más tiempo —y por ende, más cálculo— a un problema, el modelo puede ofrecer mejores resultados. Este fenómeno se conoce como escalado en el tiempo de prueba, donde un modelo asigna dinámicamente recursos de cálculo durante la inferencia para razonar sobre los problemas.

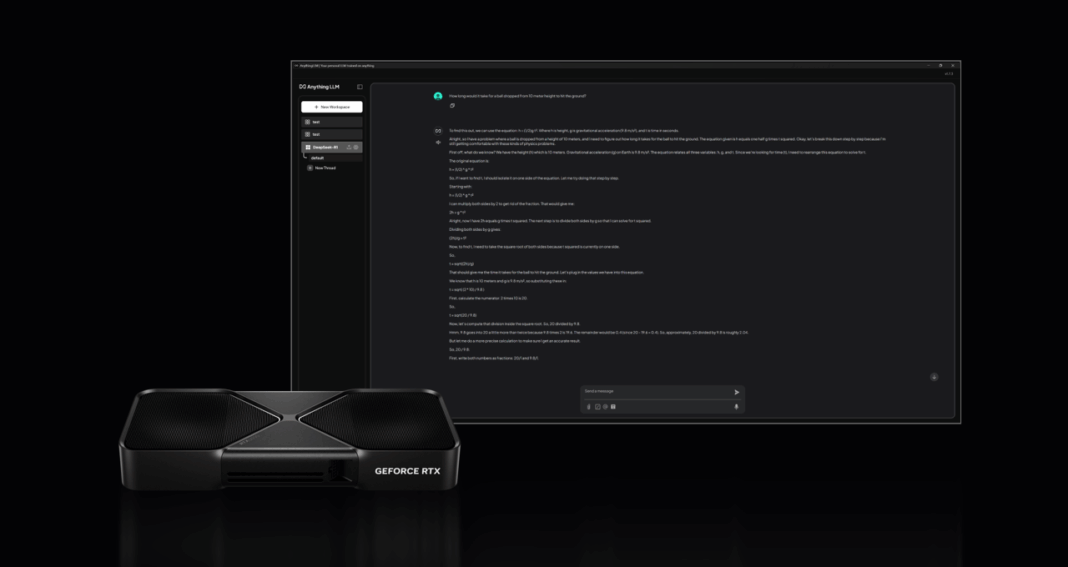

Los modelos de razonamiento pueden mejorar la experiencia del usuario en PCs al comprender profundamente las necesidades del usuario, tomando acciones en su nombre y permitiéndoles proporcionar retroalimentación sobre el proceso de pensamiento del modelo, lo que desbloquea flujos de trabajo autónomos para resolver tareas complejas y de múltiples pasos, como analizar investigaciones de mercado, realizar problemas matemáticos complicados, depurar código y más.

La diferencia DeepSeek

La familia de modelos destilados DeepSeek-R1 se basa en un gran modelo de mezcla de expertos (MoE) con 671 mil millones de parámetros. Los modelos MoE consisten en múltiples modelos expertos más pequeños para resolver problemas complejos. Los modelos DeepSeek dividen aún más el trabajo y asignan subtareas a conjuntos más pequeños de expertos.

DeepSeek empleó una técnica llamada destilación para construir una familia de seis modelos estudiantiles más pequeños —que van de 1.5 a 70 mil millones de parámetros— a partir del gran modelo de 671 mil millones de parámetros. Las capacidades de razonamiento del mayor modelo DeepSeek-R1 fueron transferidas a los modelos estudiantiles más pequeños Llama y Qwen, resultando en potentes modelos de razonamiento más pequeños que funcionan localmente en PCs RTX AI con un rendimiento rápido.

Rendimiento máximo en RTX

La velocidad de inferencia es fundamental para esta nueva clase de modelos de razonamiento. Las GPUs GeForce RTX 50, fabricadas con núcleos Tensor de quinta generación