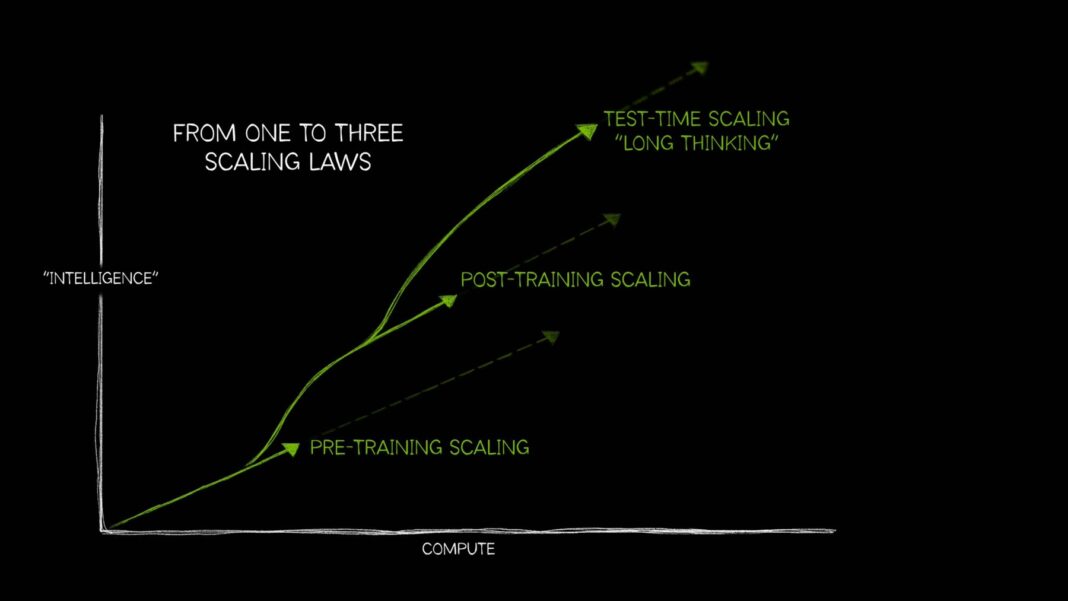

En el ámbito de la inteligencia artificial (IA), el paradigma del desarrollo ha evolucionado significativamente. Tradicionalmente, el avance se basaba en una idea simple: a mayor capacidad de cómputo, más datos de entrenamiento y un mayor número de parámetros, mejor sería el modelo de IA. Sin embargo, actualmente se reconoce la necesidad de tres leyes que guían el rendimiento de los modelos de IA mediante el uso de recursos computacionales, que son el escalado en preentrenamiento, el escalado post-entrenamiento y el escalado en tiempo de prueba.

Estos principios no solo reflejan la evolución de las técnicas en el campo de la IA, sino que también muestran cómo la aplicación de recursos de cómputo puede impactar el desempeño en diversos casos de uso cada vez más complejos. Entre estos, el escalado en tiempo de prueba ha cobrado relevancia, ya que permite que los modelos de razonamiento de IA, una nueva clase de modelos de lenguaje grande (LLMs), realicen múltiples pasadas de respuesta para resolver problemas complejos, describiendo además los pasos necesarios para abordar las tareas.

Escalado en preentrenamiento

El escalado en preentrenamiento es el principio inicial del desarrollo de la IA. Este enfoque demuestra que al aumentar el tamaño del conjunto de datos de entrenamiento, la cantidad de parámetros del modelo y los recursos computacionales, se pueden lograr mejoras predecibles en la inteligencia y precisión del modelo. Los elementos interrelacionados de datos, tamaño del modelo y cómputo son fundamentales, y según esta ley, cuando modelos más grandes reciben más datos, su rendimiento general se incrementa. Esto ha generado la necesidad de recursos de cómputo acelerados para ejecutar cargas de trabajo de entrenamiento más grandes.

Este principio ha llevado a la creación de modelos de gran envergadura que han alcanzado capacidades innovadoras y ha fomentado avances significativos en la arquitectura de los modelos, como los populares modelos de transformadores y las técnicas de entrenamiento distribuido, que requieren un uso extensivo de cómputo. A medida que la generación humana de datos multimodales en forma de texto, imágenes, audio y video continúa creciendo, estos datos se utilizarán para entrenar poderosos modelos de IA en el futuro.

Escalado post-entrenamiento

El preentrenamiento de un modelo base de IA no es accesible para todas las organizaciones, ya que demanda una inversión considerable, expertos calificados y conjuntos de datos adecuados. Sin embargo, una vez que un modelo ha sido preentrenado y liberado, se reduce la barrera para la adopción de la IA, permitiendo que otros lo adapten a sus propias aplicaciones. Este proceso genera una demanda acumulativa de cómputo acelerado tanto en empresas como en la comunidad de desarrolladores.

El desarrollo de un ecosistema de modelos derivados puede requerir hasta 30 veces más recursos computacionales que el preentrenamiento original. Las técnicas de post-entrenamiento pueden mejorar la especificidad y relevancia de un modelo para un caso de uso particular. Por ejemplo, un modelo de lenguaje grande podría ajustarse para realizar análisis de sentimiento o traducción, incorporando vocabulario específico de sectores como la salud o el derecho.

El escalado post-entrenamiento plantea que el rendimiento de un modelo preentrenado puede mejorar aún más mediante técnicas como el ajuste fino, la poda, la cuantización, la destilación y el aprendizaje por refuerzo, además de la generación de datos sintéticos. Estas prácticas optimizan el modelo para que responda de manera más eficiente y relevante ante tareas específicas.

Escalado en tiempo de prueba

El escalado en tiempo de prueba, también denominado razonamiento a largo plazo, ocurre durante la inferencia. En lugar de que los modelos generen respuestas rápidas a preguntas simples, este enfoque permite asignar un mayor esfuerzo computacional para analizar preguntas complejas, lo que requiere múltiples pasos de razonamiento. Esta técnica es especialmente útil en escenarios que demandan la resolución de problemas elaborados y la planificación a largo plazo.

Por ejemplo, en el ámbito de la salud, los modelos podrían analizar grandes volúmenes de datos para inferir la progresión de una enfermedad y predecir complicaciones potenciales. En el comercio minorista, puede facilitar la toma de decisiones complejas, como la previsión de demanda o la optimización de rutas de suministro, ayudando así a las empresas a reducir riesgos y abordar desafíos de escalabilidad.

Los modelos de razonamiento de IA están evolucionando rápidamente, con el lanzamiento reciente de modelos como OpenAI o1-mini y o3-mini. Estos modelos requieren un considerable aumento de cómputo para generar respuestas correctas en situaciones de complejidad, lo que significa que las empresas deben escalar sus recursos de computación acelerada para ofrecer herramientas de IA que soporten la resolución de problemas complicados.