La inteligencia artificial avanza con un enfoque integral que requiere una infraestructura computacional robusta, que incluye procesadores acelerados y tecnologías de red, conectadas a compiladores optimizados, algoritmos y aplicaciones. NVIDIA, una empresa líder en este campo, está impulsando la innovación en múltiples industrias. Durante la semana actual, del 24 al 28 de abril, se lleva a cabo la Conferencia Internacional sobre Representaciones de Aprendizaje (ICLR) en Singapur, donde se presentan más de 70 documentos elaborados por investigadores de NVIDIA que exploran desarrollos en inteligencia artificial aplicables a vehículos autónomos, atención médica, creación de contenido multimodal, robótica, entre otros.

Bryan Catanzaro, vicepresidente de investigación en aprendizaje profundo aplicado en NVIDIA, destacó: “ICLR es una de las conferencias sobre inteligencia artificial más influyentes del mundo, donde los investigadores presentan innovaciones técnicas significativas que impulsan cada industria. La investigación que presentamos este año tiene como objetivo acelerar todos los niveles de la infraestructura computacional para amplificar el impacto y la utilidad de la IA en distintos sectores”.

Investigaciones que Abordan Desafíos Reales

Entre los documentos presentados en la ICLR, hay investigaciones pioneras en IA generativa multimodal y métodos novedosos para el entrenamiento de IA y la generación de datos sintéticos. Algunos de los trabajos más destacados son:

- Fugatto: Este modelo de IA generativa de audio es sumamente flexible, permitiendo la generación o transformación de una mezcla de música, voces y sonidos a partir de sugerencias descritas mediante texto y archivos de audio. Otros modelos de NVIDIA mejoran la comprensión del habla por parte de modelos de lenguaje a gran escala.

- HAMSTER: La investigación muestra que un diseño jerárquico para modelos de acción, lenguaje y visión puede mejorar la transferencia de conocimiento desde datos de ajuste fino de dominio diferente, aumentando las capacidades de un robot en escenarios de prueba.

- Hymba: Esta familia de pequeños modelos de lenguaje utiliza una arquitectura híbrida que combina los beneficios de los modelos de transformadores y modelos de espacio de estado, mejorando la recuperación de información y la capacidad de resumen de contexto, además de optimizar el rendimiento.

- LongVILA: Este enfoque optimiza el entrenamiento y la inferencia de modelos de lenguaje visual para comprender videos largos, consiguiendo un rendimiento sin precedentes en nueve conjuntos de datos de video populares.

- LLaMaFlex: Este trabajo presenta una técnica nueva de generación en cero disparos para crear modelos de lenguaje comprimidos, lo que podría reducir significativamente los costos de entrenamiento en comparación con otros métodos tradicionales.

- Proteina: Este modelo tiene la capacidad de generar estructuras de proteínas diversas y diseñables, utilizando una arquitectura de modelo transformador con un número considerablemente mayor de parámetros que modelos previos.

- SRSA: Este marco busca enseñar a los robots nuevas tareas utilizando una biblioteca de habilidades existente, mejorando las tasas de éxito en tareas desconocidas en un 19% al predecir la habilidad más relevante a aplicar.

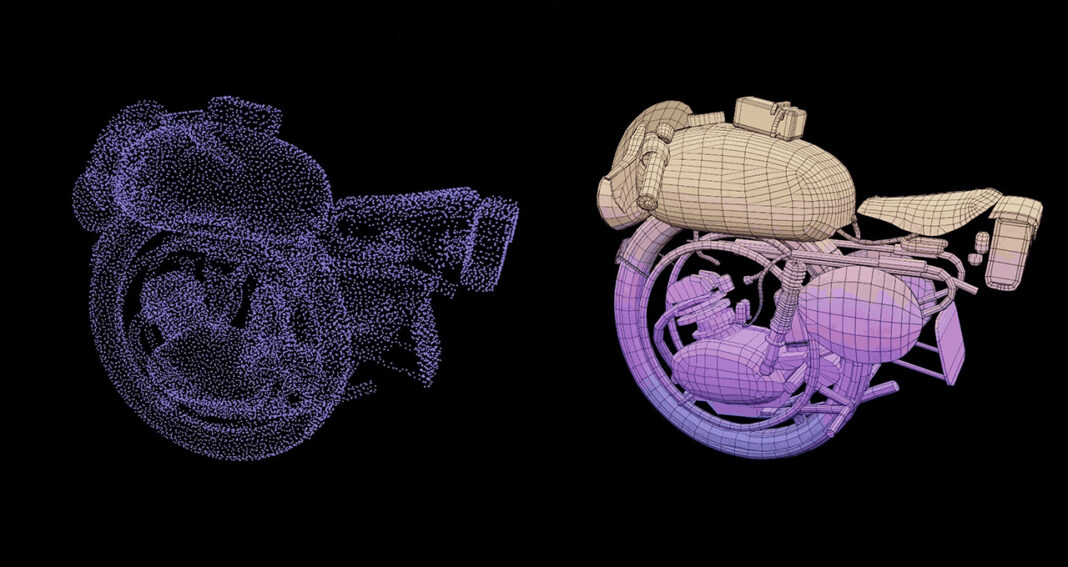

- STORM: Este modelo puede reconstruir escenas dinámicas al aire libre, logrando una representación 3D precisa a partir de pocas imágenes, lo que abre nuevas oportunidades en el desarrollo de vehículos autónomos.

Con el apoyo de un equipo global de aproximadamente 400 expertos en diversas áreas, NVIDIA continúa liderando en investigación sobre inteligencia artificial, arquitecturas de computación, gráficos y robótica, entre otros campos. La amplia variedad de investigaciones presentadas en esta conferencia refuerza su compromiso con el avance de la tecnología y su aplicación en la vida cotidiana.