A continuación se presenta una reescritura de la noticia solicitada:

Una conferencia de tecnología avanzada para arquitectos de procesadores y sistemas de la industria y la academia se ha convertido en un foro importante para el mercado de computación en centros de datos, valorado en billones de dólares.

Avances en la plataforma Blackwell de NVIDIA

En el evento Hot Chips 2024, ingenieros senior de NVIDIA presentarán los últimos avances que impulsan la plataforma NVIDIA Blackwell, así como investigaciones sobre refrigeración líquida para centros de datos y agentes de IA para el diseño de chips.

Compartirán cómo:

- NVIDIA Blackwell integra múltiples chips, sistemas y software NVIDIA CUDA para potenciar la próxima generación de IA en diversos casos de uso, industrias y países.

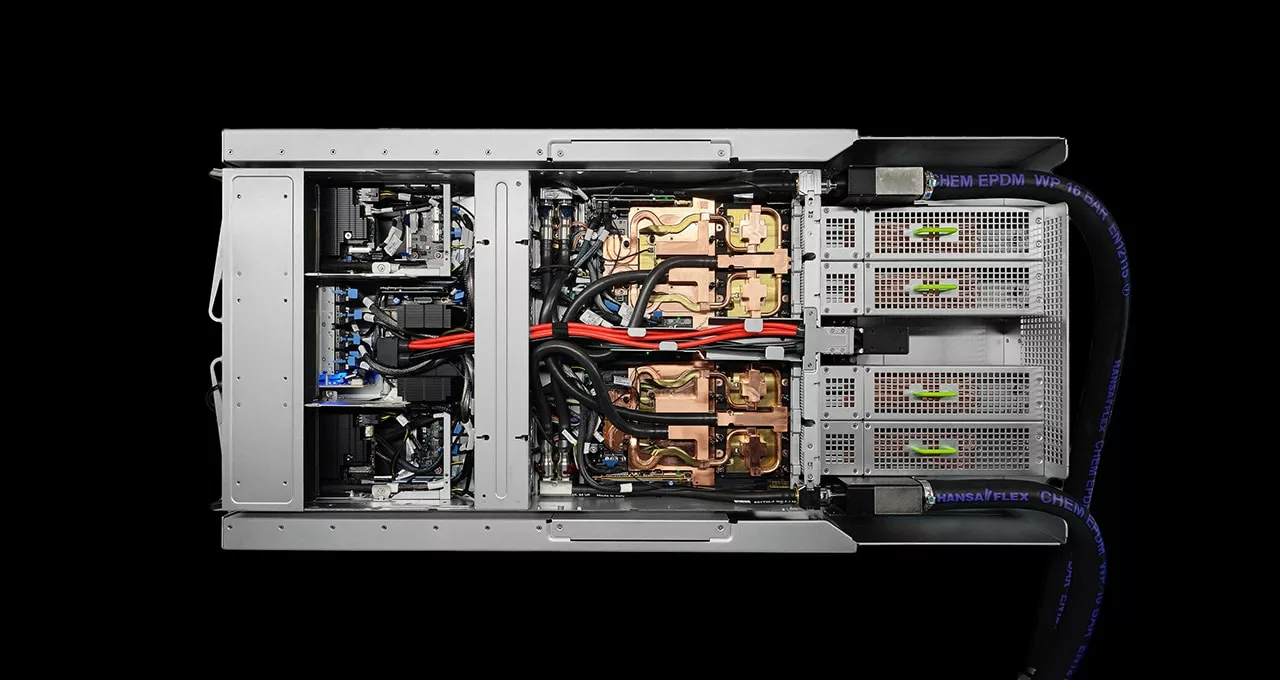

- NVIDIA GB200 NVL72 — una solución de múltiples nodos, refrigerada por líquido, que conecta 72 GPUs Blackwell y 36 CPUs Grace — establece un nuevo estándar para el diseño de sistemas de IA.

- La tecnología de interconexión NVLink proporciona comunicación GPU a GPU, permitiendo un flujo de datos récord y una inferencia de baja latencia para la IA generativa.

- El sistema de cuantización NVIDIA Quasar empuja los límites de la física para acelerar la computación de IA.

- Investigadores de NVIDIA están desarrollando modelos de IA que ayudan en la creación de procesadores para IA.

Una charla sobre NVIDIA Blackwell, que tuvo lugar el 26 de agosto, también destacó nuevos detalles arquitectónicos y ejemplos de modelos de IA generativa corriendo en silicio Blackwell.

Esta presentación fue precedida por tres tutoriales el 25 de agosto, que cubrieron cómo las soluciones híbridas de refrigeración líquida pueden ayudar a los centros de datos a realizar la transición hacia una infraestructura más eficiente en energía y cómo los modelos de IA, incluidos los agentes impulsados por modelos de lenguaje grande (LLM), pueden asistir a los ingenieros en el diseño de la próxima generación de procesadores.

En conjunto, estas presentaciones mostraron las formas en que los ingenieros de NVIDIA están innovando en cada área de la computación y el diseño de centros de datos para ofrecer un rendimiento, eficiencia y optimización sin precedentes.

Prepárate para Blackwell

NVIDIA Blackwell representa el desafío total de computación de pila completa. Comprende múltiples chips de NVIDIA, incluyendo GPUs Blackwell, CPUs Grace, la unidad de procesamiento de datos BlueField, la tarjeta de interfaz de red ConnectX, el conmutador NVLink, el conmutador Ethernet Spectrum y el conmutador InfiniBand Quantum.

Ajay Tirumala y Raymond Wong, directores de arquitectura en NVIDIA, proporcionaron una primera mirada a la plataforma y explicaron cómo estas tecnologías trabajan juntas para ofrecer un nuevo estándar en el rendimiento de IA y computación acelerada, al tiempo que avanzan la eficiencia energética.

La solución multinodo NVIDIA GB200 NVL72 es un ejemplo perfecto. La inferencia de LLM requiere generación de tokens con baja latencia y alto rendimiento. La GB200 NVL72 actúa como un sistema unificado para entregar inferencia hasta 30 veces más rápida para cargas de trabajo de LLM, desbloqueando la capacidad de ejecutar modelos de billones de parámetros en tiempo real.

Tirumala y Wong también discutieron cómo el sistema de cuantización NVIDIA Quasar — que une innovaciones algorítmicas, bibliotecas y herramientas de software de NVIDIA, y el motor Transformer de segunda generación de Blackwell — soporta alta precisión en modelos de baja precisión, destacando ejemplos que utilizan LLM y IA generativa visual.

Manteniendo los centros de datos frescos

El tradicional zumbido de los centros de datos refrigerados por aire podría convertirse en un recuerdo del pasado a medida que los investigadores desarrollen soluciones más eficientes y sostenibles que utilicen refrigeración híbrida, una combinación de refrigeración por aire y líquido.

Las técnicas de refrigeración líquida mueven el calor lejos de los sistemas de manera más eficiente que el aire, facilitando que los sistemas informáticos se mantengan frescos incluso mientras procesan grandes cargas de trabajo. Además, el equipo para la refrigeración líquida ocupa menos espacio y consume menos energía que los sistemas de refrigeración por aire, permitiendo a los centros de datos adicionar más racks de servidores — y, por ende, más potencia de cálculo — en sus instalaciones.

Ali Heydari, director de refrigeración de centros de datos e infraestructura en NVIDIA, presentará varios diseños para centros de datos refrigerados de manera híbrida.

Algunos diseños retrofitting instalaciones existentes refrigeradas por aire con unidades de refrigeración líquida, ofreciendo una solución rápida y sencilla para añadir capacidades de refrigeración líquida a racks existentes. Otros diseños requieren la instalación de tuberías para refrigeración líquida directa al chip usando unidades de distribución de refrigeración o sumergiendo completamente servidores en tanques de refrigeración por inmersión. Aunque estas opciones requieren una mayor inversión inicial, conducen a ahorros sustanciales tanto en consumo de energía como en costos operativos.

Heydari también compartirá el trabajo de su equipo como parte de un programa del Departamento de Energía de EE.UU. para desarrollar tecnologías avanzadas de refrigeración de centros de datos. Como parte del proyecto, el equipo está utilizando la plataforma NVIDIA Omniverse para crear gemelos digitales informados por la física que les ayudarán a modelar el consumo de energía y la eficiencia de la refrigeración para optimizar sus diseños de centros de datos.

Agentes de IA apoyan el diseño de procesadores

El diseño de semiconductores es un desafío monumental a escala microscópica. Los ingenieros que desarrollan procesadores de vanguardia luchan por encajar la mayor cantidad de potencia de cálculo posible en un trozo de silicio de pocos centímetros, poniendo a prueba los límites de lo que es físicamente viable.

Los modelos de IA están apoyando su trabajo al mejorar la calidad y productividad del diseño, aumentando la eficiencia de los procesos manuales y automatizando algunas tareas que consumen tiempo. Los modelos incluyen herramientas de predicción y optimización para ayudar a los ingenieros a analizar y mejorar rápidamente los diseños, así como LLM que pueden asistir a los ingenieros respondiendo preguntas, generando código, depurando problemas de diseño, entre otros.

Mark Ren, director de investigación en automatización de diseño en NVIDIA, ofrecerá una visión general de estos modelos y sus usos en un tutorial. En una segunda sesión, se centrará en sistemas de IA basados en agentes para el diseño de chips.

Los agentes de IA impulsados por LLM pueden ser dirigidos para completar tareas de manera autónoma, desbloqueando amplias aplicaciones en diversas industrias. En el diseño de microprocesadores, los investigadores de NVIDIA están desarrollando sistemas basados en agentes que pueden razonar y tomar decisiones utilizando herramientas de diseño de circuitos personalizadas, interactuar con diseñadores experimentados y aprender de una base de datos de experiencias humanas y de agentes.

Los expertos de NVIDIA no solo están construyendo esta tecnología — también la están utilizando. Ren compartirá ejemplos de cómo los ingenieros pueden usar agentes de IA para el análisis de informes de temporización, procesos de optimización de clústeres de celdas y generación de código. El trabajo de optimización de clústeres de celdas ganó recientemente el premio al mejor artículo en el primer taller internacional de IEEE sobre diseño asistido por LLM.