DeepSeek-R1 es un modelo abierto con capacidades de razonamiento de última generación. En lugar de ofrecer respuestas directas, modelos de razonamiento como DeepSeek-R1 realizan múltiples pasadas de inferencia sobre una consulta, utilizando métodos de cadena de pensamiento, consenso y búsqueda para generar la mejor respuesta.

Realizar esta secuencia de pasadas de inferencia — usando razonamiento para llegar a la mejor respuesta — se conoce como escalado en el tiempo de prueba. DeepSeek-R1 es un ejemplo perfecto de esta ley de escalado, demostrando por qué la computación acelerada es tan importante para las demandas de la inferencia en inteligencia artificial agente.

DeepSeek-R1 — un ejemplo perfecto de escalado en el tiempo de prueba

DeepSeek-R1 es un modelo de mezcla de expertos (MoE) de gran tamaño. Incorpora unos impresionantes 671 mil millones de parámetros — 10 veces más que muchos otros modelos de lenguaje abiertos populares — y soporta una larga longitud de contexto de entrada de 128,000 tokens. Además, el modelo utiliza un número extremo de expertos por capa. Cada capa de R1 cuenta con 256 expertos, con cada token dirigido a ocho expertos separados en paralelo para su evaluación.

Para ofrecer respuestas en tiempo real para R1, se requieren muchas GPU con alto rendimiento de computación, conectadas con comunicación de alta capacidad y baja latencia para dirigir los tokens de entrada a todos los expertos para la inferencia. Combinado con las optimizaciones de software disponibles en el microservicio NIM de NVIDIA, un solo servidor con ocho GPU H200 conectadas utilizando NVLink y NVLink Switch puede ejecutar el modelo completo de 671 mil millones de parámetros de DeepSeek-R1 a una velocidad de hasta 3,872 tokens por segundo. Este rendimiento se logra gracias a la arquitectura NVIDIA Hopper que utiliza el motor FP8 Transformer en cada capa y los 900 GB/s de ancho de banda NVLink para la comunicación entre expertos MoE.

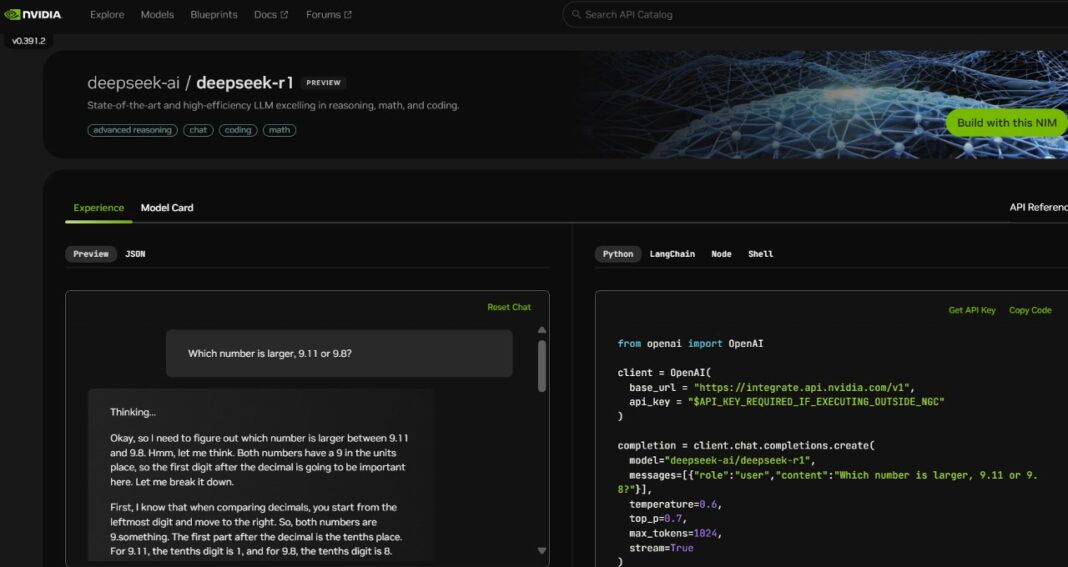

Comienza ahora con el microservicio DeepSeek-R1 NIM

Los desarrolladores pueden experimentar el microservicio DeepSeek-R1, ahora disponible. Con NVIDIA NIM, las empresas pueden desplegar DeepSeek-R1 con facilidad y asegurarse de obtener la alta eficiencia necesaria para los sistemas de inteligencia artificial agente.