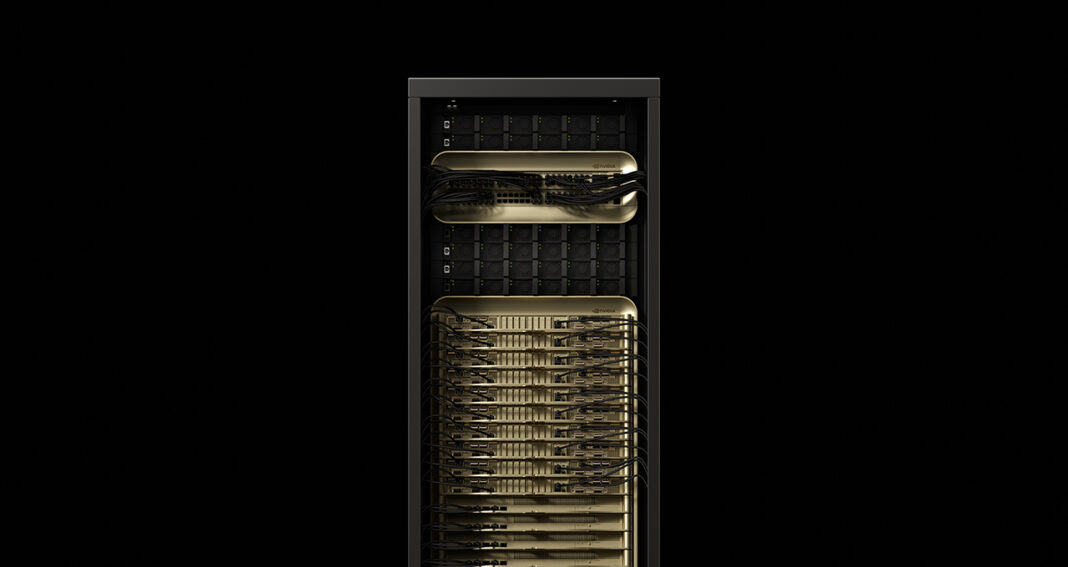

En las últimas pruebas de MLPerf Inference V5.0, que evalúan los escenarios de inferencia más desafiantes, la plataforma NVIDIA Blackwell ha logrado establecer nuevos récords. Este evento marca la primera vez que NVIDIA presenta resultados utilizando su sistema GB200 NVL72, una solución de escala de rack diseñada específicamente para el razonamiento de inteligencia artificial.

La implementación de tecnología de vanguardia en inteligencia artificial demanda una infraestructura computacional innovadora, que se conoce como fábricas de IA. A diferencia de los centros de datos convencionales, estas fábricas no solo almacenan y procesan datos, sino que también producen inteligencia a gran escala al transformar información en tiempo real. Su objetivo es ofrecer respuestas precisas a las consultas de los usuarios de manera rápida y económica, maximizando la capacidad de respuesta para una amplia gama de usuarios.

NVIDIA Blackwell establece nuevos récords

El sistema GB200 NVL72, que conecta 72 GPUs Blackwell de NVIDIA para funcionar como una única y poderosa GPU, proporcionó un rendimiento hasta 30 veces superior en el benchmark Llama 3.1 405B, en comparación con el sistema H200 NVL8 de NVIDIA en esta edición. Este notable avance se logró gracias a un rendimiento por GPU más de tres veces superior y un dominio de interconexión NVIDIA NVLink nueve veces más grande.

Contrariamente a otras empresas que realizan pruebas de benchmark MLPerf en su hardware para evaluar el rendimiento, solo NVIDIA y sus socios publicaron resultados en el benchmark Llama 3.1 405B.

En las implementaciones de inferencia productiva, existen restricciones de latencia basadas en dos métricas importantes. La primera es el tiempo hasta el primer token (TTFT), que mide cuánto tiempo tarda un usuario en recibir una respuesta a su consulta. La segunda medida es el tiempo por cada token de salida (TPOT), que indica la rapidez con que se entregan los tokens al usuario.

El nuevo benchmark Llama 2 70B Interactive tiene un TPOT cinco veces más corto y un TTFT 4.4 veces inferior, lo que refleja una experiencia de usuario más satisfactoria. En esta prueba, la presentación de NVIDIA utilizando un sistema DGX B200 con ocho GPUs Blackwell triplicó el rendimiento en comparación con ocho GPUs H200, estableciendo un estándar elevado para esta versión más difícil del benchmark Llama 2 70B.

La combinación de la arquitectura Blackwell con su pila de software optimizada proporciona nuevos niveles de rendimiento en inferencia, allanan el camino para que las fábricas de IA ofrezcan una inteligencia más avanzada, un mayor rendimiento y tasas de tokens más rápidas.

El valor de la fábrica de IA NVIDIA Hopper sigue en aumento

La arquitectura NVIDIA Hopper, que se introdujo en 2022, es fundamental para muchas de las fábricas de inferencia de IA actuales y sigue siendo esencial para el entrenamiento de modelos. Gracias a la optimización continua del software, NVIDIA ha aumentado la capacidad de rendimiento en las fábricas de IA basadas en Hopper, resultando en un valor superior.

En el benchmark Llama 2 70B, que se presentó hace un año en MLPerf Inference v4.0, el rendimiento de la GPU H100 ha mejorado en un 1.5x. Por su parte, la GPU H200, que se basa en la misma arquitectura Hopper pero con memoria más grande y rápida, ha incrementado esta mejora hasta un 1.6x.

Hopper ha participado en todos los benchmarks, incluyendo el nuevo Llama 3.1 405B, el Llama 2 70B Interactive y pruebas de redes neuronales gráficas. Esta versatilidad indica que Hopper puede manejar una amplia gama de cargas de trabajo y responder a los desafíos que surgen a medida que los modelos y escenarios de uso se vuelven más complejos.

Los resultados de este ciclo de MLPerf, en el que 15 socios han presentado resultados sobresalientes en la plataforma NVIDIA, son testimonio de la amplitud y el impacto global de su tecnología. Entre los colaboradores se encuentran ASUS, Cisco, Google Cloud, Oracle Cloud Infrastructure y otros.

La labor de MLCommons para evolucionar constantemente la suite de benchmarks MLPerf Inference es vital. Esto permite mantener el ritmo con los últimos desarrollos en inteligencia artificial y proporcionar a los responsables de decisiones de TI datos de rendimiento rigurosos y revisados por pares, facilitando la selección de la infraestructura de IA más adecuada.